- 판매자 배송

-

[중고] 강화학습 첫걸음 (텐서플로로 살펴보는 Q 러닝, MDP, DQN, A3C 강화학습 알고리즘) - 텐서플로로 살펴보는 Q 러닝, MDP, DQN, A3C 강화학습 알고리즘

| 머신러닝/딥러닝 첫걸음 시리즈

| 머신러닝/딥러닝 첫걸음 시리즈 - 아서 줄리아니 (지은이),송교석 (옮긴이)한빛미디어2017-12-22

- 배송료택배 4,000원, 도서/산간 1,000원

- 판매자

- 출고예상일통상 48시간 이내

- [중고] 강화학습 첫걸음 (텐서플로로 살펴보는 Q 러닝, MDP, DQN, A3C 강화학습 알고리즘) - 텐서플로로 살펴보는 Q 러닝, MDP, DQN, A3C 강화학습 알고리즘

- 9,900원 (정가대비 45% 할인) [중고-최상]

- US, 해외배송불가, 판매자 직접배송

- 중고샵 회원간 판매상품은 판매자가 직접 등록/판매하는 오픈마켓 상품으로, 중개 시스템만 제공하는 알라딘에서는 상품과 내용에 대해 일체 책임지지 않습니다.

책 정보

· ISBN : 9791162240298

· 쪽수 : 180쪽

· 출판일 : 2017-12-22

책 소개

목차

PART I 주요 알고리즘 및 구현

CHAPTER 1 강화학습 소개

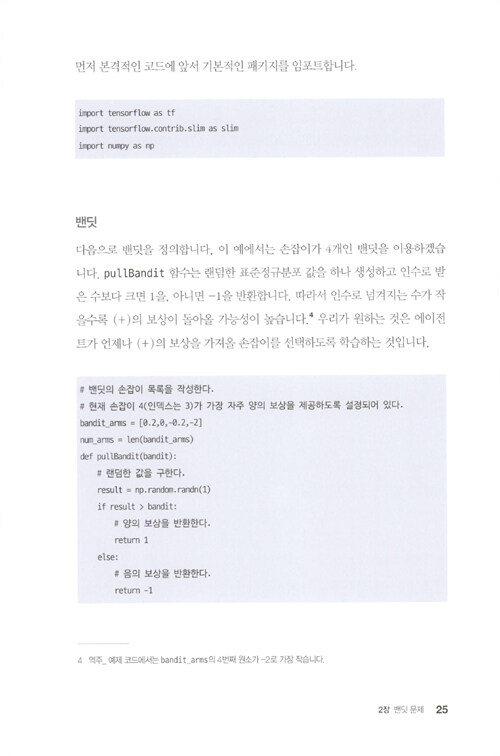

CHAPTER 2 밴딧 문제

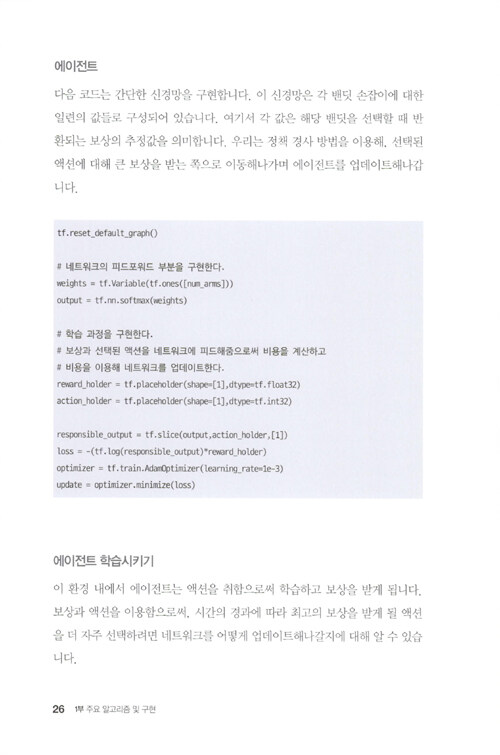

2.1 정책 경사

2.2 멀티암드 밴딧의 구현

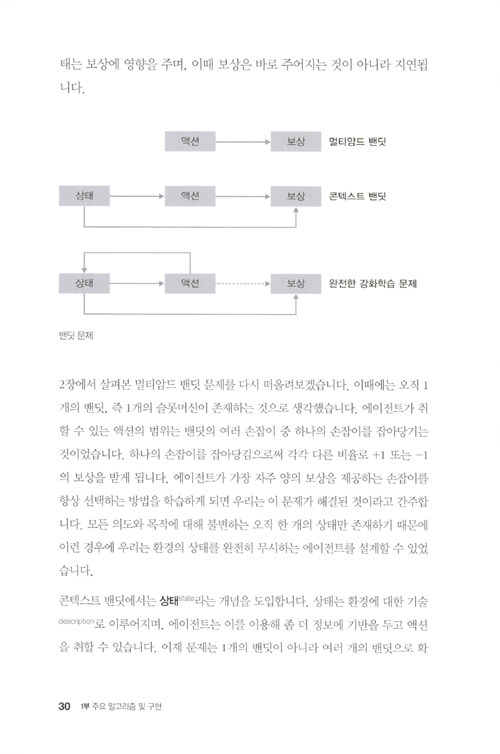

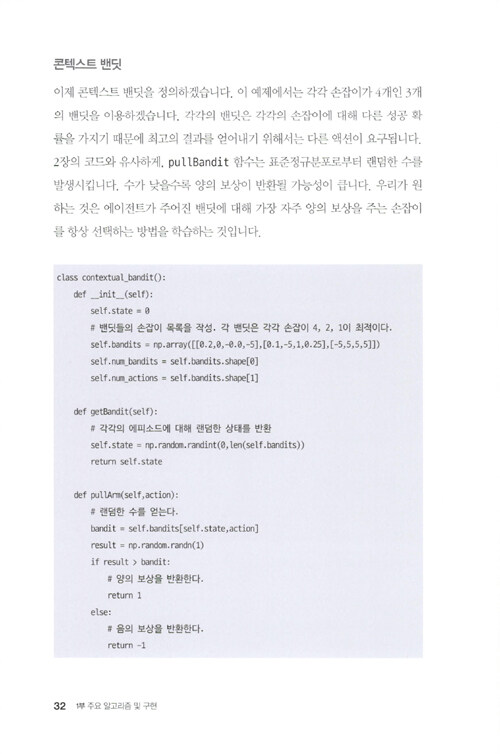

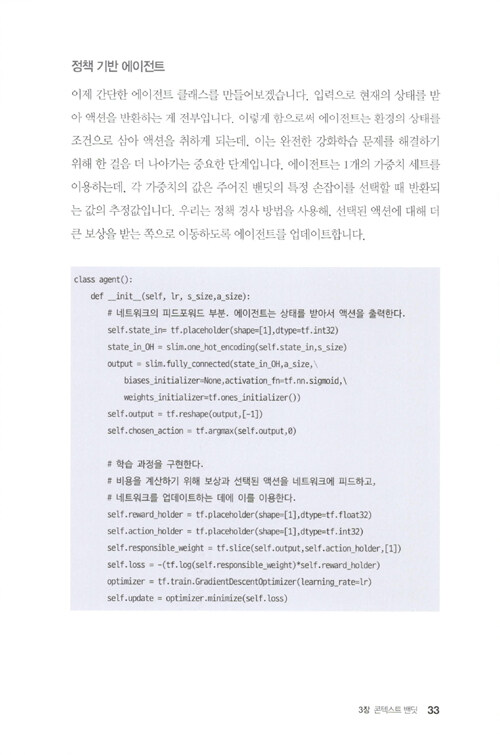

CHAPTER 3 콘텍스트 밴딧

3.1 콘텍스트 밴딧 구현

CHAPTER 4 마르코프 결정 과정

4.1 기본적인 정책 경사 에이전트 구현

CHAPTER 5 Q 러닝

5.1 테이블 환경에 대한 테이블식 접근법

5.2 신경망을 통한 Q 러닝

CHAPTER 6 딥 Q 네트워크

6.1 개선 1: 합성곱 계층

6.2 개선 2: 경험 리플레이

6.3 개선 3: 별도의 타깃 네트워크

6.4 DQN을 넘어서

6.5 더블 DQN

6.6 듀얼링 DQN

6.7 모든 것을 조합하기

6.8 개선된 딥 Q 네트워크 구현

CHAPTER 7 부분관찰성과 순환 신경망

7.1 부분관찰성 문제

7.2 제한되고 변화하는 세계 이해하기

7.3 순환 신경망

7.4 텐서플로 구현을 위한 변경점

7.5 제한된 그리드 세계

7.6 DRQN 구현

CHAPTER 8 비동기적 어드밴티지 액터-크리틱

8.1 A3C의 세 가지 A

8.2 A3C 구현

8.3 <둠> 게임 플레이하기

PART II 심화 주제

CHAPTER 9 에이전트의 생각과 액션 시각화

9.1 컨트롤 센터의 인터페이스

9.2 에이전트의 머릿속 들여다보기

9.3 강화학습 컨트롤 센터 이용

CHAPTER 10 환경 모델 활용하기

10.1 모델 기반의 강화학습 구현

CHAPTER 11 탐험을 위한 액션 선택 전략

11.1 탐험은 왜 하는 것인가요?

11.2 그리디 접근법

11.3 랜덤 접근법

11.4 엡실론-그리디 접근법

11.5 볼츠만 접근법

11.6 베이지언 접근법(드롭아웃)

11.7 각 전략의 성능 비교 및 구현

11.8 고급 기법

CHAPTER 12 정책 학습을 위한 정책 학습

12.1 메타 에이전트 만들기

12.2 메타 실험

12.3 마치며

- 구매만족도 90.0%

- 최근 6개월, 10개 평가

- 평균 출고일 3일 이내

![[중고] 강화학습 첫걸음 (텐서플로로 살펴보는 Q 러닝, MDP, DQN, A3C 강화학습 알고리즘)](https://image.aladin.co.kr/product/12572/44/cover500/k872532779_1.jpg)